自社ブログにChatGPTについて書きました

こちら、当社の宣伝になりますが、以下の記事を書きました。

クルマ用電動空気入れが良い感じです(自転車にも使える)

以前からクルマのタイヤの空気圧調整をこまめにやりたいと思っていたところ、最近、中国のおかげで電動ポンプが安く手に入るということを知った。

値段は3000円台からあるようだ。いちいちガソリンスタンドにいかなくて済むなら、妥当な金額である。

以下の製品を買ってみた。

製品の印象

思ったより小さく、広辞苑ぐらいの大きさ。これで本当に空気がはいるの?と思ってしまうほど可愛らしい装置である。

電源はシガーソケットから取るようになっている。アタッチメントを交換すると、自転車やエアクッションなどの空気入れにも使える。布製のケースも付属している。

使用テスト

説明書の手順で問題なく使用できた。設定した気圧に自動調整してストップする機能はとても便利である。さらに、空気を入れたあと、ノズルを外すときに少し空気が漏れることを見越して、やや多めに空気を入れるという芸の細かい仕様になっているのも面白い。気に入ったので、クルマの荷室に常備することにした。

ワイパーブレード干渉の解消(ワイパーアームの取付角調整)

クルマの作業備忘録。暖かくなってきて、クルマいじりがやりやすくなる季節。本日は、気になっていたワイパーブレードの干渉を修正した。

問題点

私の愛車 Peugeot 307SW (2006年式)のワイパーブレードを先日交換した。

ボッシュ製のものである。しかし、ワイパーを動かすと途中で左右のブレードが一瞬干渉し、嫌な異音もする。確認したが長さは間違っていないので、どうやらワイパーアームとブレードの相性が良くないようだ。

対策立案

干渉しているなら、アームの取付角を修正してやれば解消するはず。修正するには一度アームを外さないといけない。

ネットで調べてみると、同じ車種のワイパーブレードを外す方法が分かった。

ネジを外し、プーラー(Puller)で引く抜くというものである。

プーラーは中国製で1000円台から買えるようだ。

対策実施

- (1) ボンネットを開け、ワイパーアームの固定ナットをソケットレンチで外す。これは簡単に外れた。

- (2) プーラーの爪をアームにはめ込んで、中央の押し込み部をアームの駆動軸に垂直に当たるように合わせ込む。

- (3) プーラーの押し込み部をソケットレンチで締め込んでいく。締め込むことでプーラーの爪がアームを引き上げる仕組み。

- (4) 工具の精度があまり良くないので、多少コツが必要だが、アームは外れた。

- (5) アームの角度を少しかえて取り付けなおす。(外す前にブレード先端の位置をテープ等でマーキングしておくと分かりやすい)

- (6) エンジンを掛け、アームを動かしてみる。一回目は角度の変化が小さすぎてまだ干渉している。再度角度を変えて取り付け直してOKとなった。

以上で問題は解決した。とても簡単な作業であった。

スピーカーの修理:JBL J216PROのツィーター交換とエッジ軟化処理

自宅の作業部屋のスピーカーは、1992年の上京当時に秋葉原(確かサトー無線)で粘って粘って値切って買ったJBLのJ216PROというやつである。そろそろ30年目になるベテランだ。独特の元気の良い音色が気に入っているので、メンテナンスしながらずっと使っている。

最近広域の伸びが悪くなってきている気がしていたので、久しぶりにネットワークのコンデンサーを交換した。ついでにターミナル(端子台)も交換してバナナプラグが使えるようにしてみた。内部配線も全交換した。

ツィーター故障

ところが何をミスったのか、この交換作業が終わったあと左右ともツイーターが鳴らなくなってしまった!過去にも何度かコンデンサー交換はやったことがあり、手慣れた作業なので特にミスしたはずはないのだが。確認すると間違いなく配線には信号電流が流れているので、配線には間違いがない。やはりツィーターのほうが壊れてしまったのだ。

まずはツィーターの分解修理に挑戦してみた。プラスティックの外装にツィーター本体がホットグルーで固定されている。まずこれをハンダごてで溶かす。そして、プラ外装から本体を外そうと試みた。しかし、外装のプラスティックが崩れそうで上手くいかない。30年の経年劣化によりプラスティックが脆くなっているのである。無理やり分解するとおそらくプラスティックが割れてしまい、再利用不能になるだろう。それでは分解修理する意味がない。

やむを得ず修理は断念し、新しいツィーターに交換することにした。

ツィーター交換とコンデンサ調製

オリジナルと同じツィーターはもう手に入らないので、オリジナルと似た音色傾向になるだろうと想像して、チタン製のドームツィーターをネットで物色。最終的にAmazonで見つけた、DAYTON AUDIO製のDC25T-8 をというのを選んだ。寸法的にもちょうど良い。

入手したツィーターをエンクロージャーに取り付け視聴してみた。高域はよく伸びて解像度の高い繊細な音が出てきた。ただ、少し中域のボリュームが少ない印象。ネットワークのコンデンサを 6.8μF に変更して中域を増やした。エージングすると変化する可能性はあるが、とりあえず現状で試した範囲ではこれが一番音が良かった。

エッジの軟化処理は効果あり

ついでに、最近ネット情報で知ったスピーカーエッジの軟化処理をやってみた。

材質にもよるが、スピーカーのエッジは長年使っていると劣化して固くなることがある。そうなるとコーンの動きが悪くなるので、著しく音質が悪くなるのである。これを再び柔らかい状態に戻してやろうというのが軟化処理である。

J216PROのウーハーは比較的硬化しにくいとされる布製のエッジである。確かに手で触れた感じでは硬化しているようには感じない。しかし30年も経過したものなので、何かしら経年変化はしているだろう。ということで、とりあえず試しにやってみた。

ネット情報によれば軟化剤として使えるものは何種類かあるようだ。今回は一番無難そうな「クレポリメイト」を使ってみた。シリコーンオイルが主成分の艶出し剤だ。

このクレポリメイトを100均で買った絵筆につけてエッジに塗っていく。とても簡単な作業である。

スピーカーから音を出しながらどんどん塗っていくと、驚いたことにものの数分で効果が現れた。中〜低域の躍動感や解像度が増してきたのだ。バスドラムやベースの細かい音の変化が良く聞こえる。これは素晴らしい!

嬉しくなって、リビングに置いてあるミニコンポ用の十数年前のスピーカーにも塗布してみたら、同様の効果が得られた。こちらはウーハーとソフトドームツィーターにも塗布したので、高域から低域まで全域で解像感がアップした。

軟化処理にこれほど効果があるとは。古いスピーカーお使いの皆様、良かったらやってみてください。

仕上がり

数時間試聴を続けてみた感じでは、DAYTON AUDIO社のツィーターは、J216PROにそれなりに上手くマッチしたようである。

エッジの軟化処理のおかげもあってか、記憶の中にあるオリジナルのJ216PROの音に近い音になっていると思う。

キラキラとした高音、躍動感のある中低音がJBLらしい。小音量でも満足感のある音である。

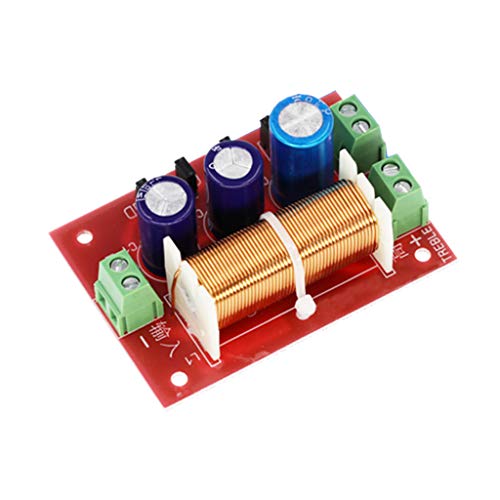

備忘録:スピーカーネットワーク YLY-2088 の回路図

ディープラーニング関連スライドを公開しました:『論文紹介 dhSegment:文書セグメンテーションのための包括的ディープラーニングアプローチ』

最近は、ディープラーニングによる画像のセマンティック・セグメンテーション(意味的領域分割)について調査していて、いくつか論文を読みました。

この論文は古文書の解析に適用した例について紹介しています。その内容をスライドにしてみました。

www.slideshare.net

ご参考まで!

(遅報告)FPGA+ディープラーニングの論文を書きました。

なかなかコンスタントにブログを更新することの難しさを実感しています。

前回記事以降、2〜3月は論文を書くのに必死でした。

ようやく完成して arXiv.org に投稿しました。(

[1803.10930] B-DCGAN:Evaluation of Binarized DCGAN for FPGA

)

FPGAでディープラーニングを動かしてみようという実証実験についての論文です。

この実験は、当社と電気通信大学さんとで実施している共同研究の1テーマとしてやったものです。

FPGAの中にDCGANのジェネレータを詰め込むのが最大の課題で、いろんな工夫を凝らして完成しました。

最大のポイントは、ニューラルネット(NN)のバイナリ化(binarize)です。

NNの計算フローのどこをどれぐらいビット削減して良いのか、試行錯誤でベストな構成を見つけました。

FPGAのロジックは、高位合成(HLS)という技術を使って、C++でスクラッチ開発しました。

NNのデコンボリューションの実装が一番大変でした。2重巡回行列の計算が必要なのです。

さらに、このC++ロジックの計算結果は、寸分違わず GPU上の Python/Theano 学習モデルと合致しなければなりません。

Python と C++ を行ったり来たりしながら計算の課程を合わせこむ作業です。

他人様が作ったTheanoライブラリの中身を解読しながらの C++プログラミングとなり、結構大変でした。

![【国内正規品】Dayton Audio DC25T-8 25mm チタンドーム ツィーター 8Ω[ペア] DC25T-8-2P 【国内正規品】Dayton Audio DC25T-8 25mm チタンドーム ツィーター 8Ω[ペア] DC25T-8-2P](https://m.media-amazon.com/images/I/41mg8J+VR0L.jpg)